Noticias

NVIDIA ha desarrollado una IA que convierte modelos 2D en 3D

La compañía que dirige Jen-Hsun Huang sigue apostando con fuerza por la inteligencia artificial. En uno de sus últimos movimientos NVIDIA ha dado forma a una IA que es capaz de convertir modelos creados en 2D en modelos 3D partiendo de un sistema que se inspira directamente en la visión humana: la interpolación diferenciable.

No te preocupes, no es difícil de entender. Cuando contemplamos el mundo que nos rodea con un solo ojo nos damos cuenta de que hemos perdido la sensación de profundidad y de tridimensionalidad que tenemos cuando utilizamos ambos ojos. Esto se debe a la combinación de imágenes capturadas por ambas retinas que se produce en el cerebro, y que resulta fundamental para conseguir ambas sensaciones.

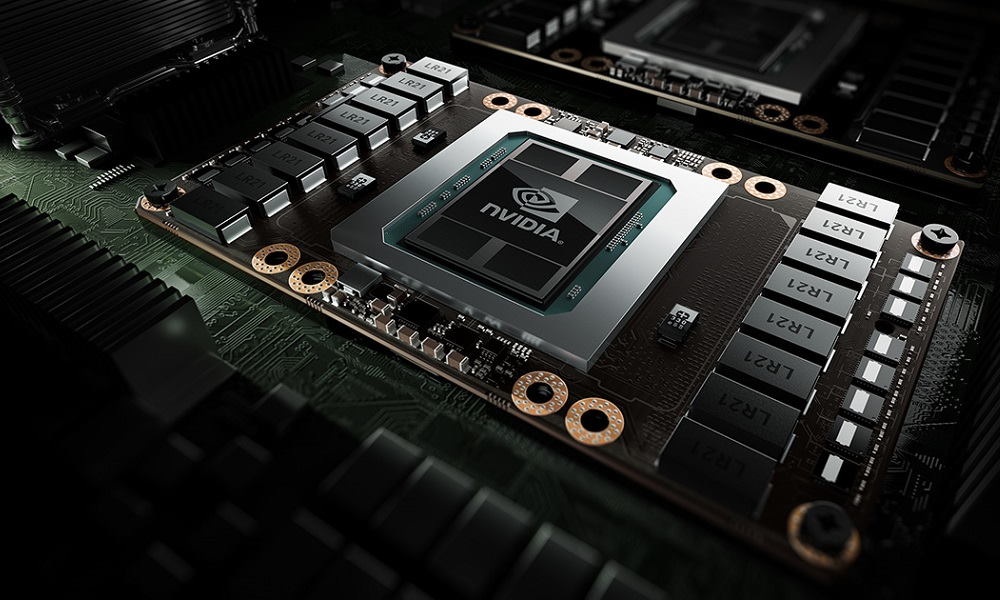

Pues bien, los investigadores de NVIDIA han llevado esa idea a la IA con la creación de un framework de renderizado llamado DIB-R, basado en la interpolación diferenciable y capaz de producir objetos 3D partiendo de objetos 2D. El gigante verde ha confirmado que solo han necesitado dos días para proporcionar a esta inteligencia artificial el entrenamiento necesario utilizando, eso sí, una potente GPU Tesla V100. Esta unidad gráfica cuenta con:

- 5.120 núcleos CUDA (shaders).

- 320 unidades de texturizado.

- 128 unidades de rasterizado.

- 640 núcleos tensor para inteligencia artificial.

- Bus de 4.096 bits.

- 32 GB de memoria HBM2.

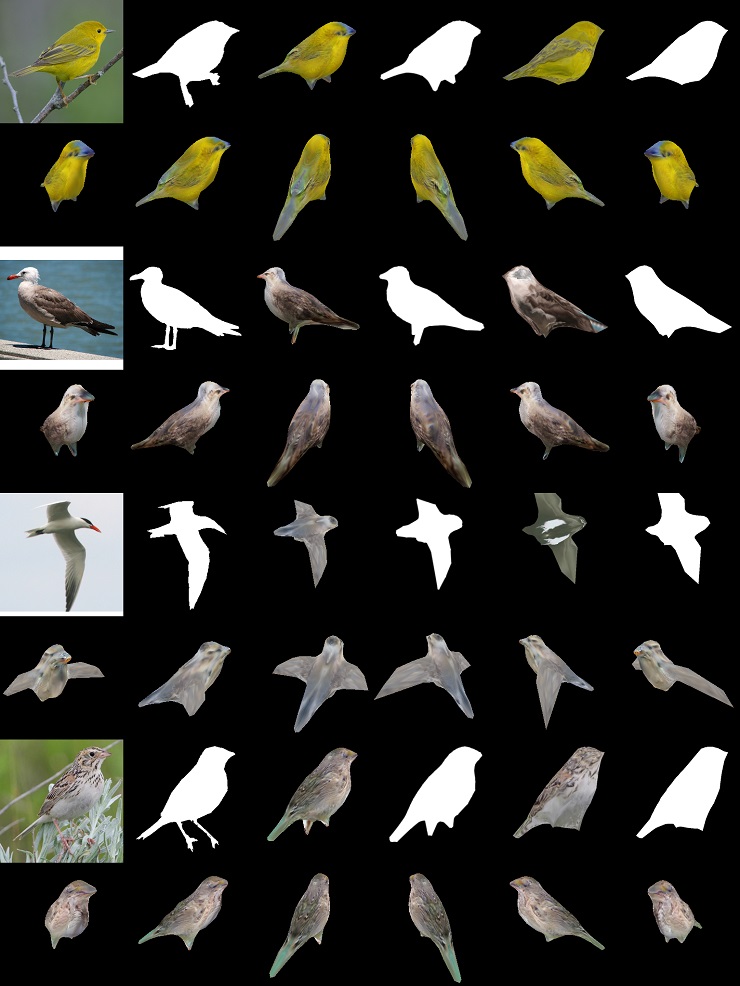

Una vez entrenado el framework DIB-R puede producir un objeto 3D a partir de una imagen 2D en menos de 100 milisegundos. Para completar el proceso parte de una plantilla 3D tradicional, una esfera poligonal que «esculpe» a partir de la información que obtiene de las imágenes 2D, generando esas sensaciones de profundidad y de tridimensionalidad a las que hemos hecho referencia.

Durante el proceso esta IA de NVIDIA lleva a cabo operaciones complejas de gran importancia, entre las que destacan la predicción específica de la forma, el color, el texturizado y la iluminación de una imagen. Esta tecnología aplicada al mundo de la robótica podría facilitar la creación de modelos autónomos que sean capaces de interactuar con el medio de una manera más eficiente y segura, gracias a sus capacidades de percepción mejoradas.

En la imagen adjunta podemos ver que los resultados finales son, en general, bastante buenos, aunque en algunos casos quedan por debajo del nivel que podríamos considerar como aceptable. Con todo, es un logro importante y representa un avance muy interesante.

-

OpiniónHace 6 días

OpiniónHace 6 días10 predicciones para los proveedores de servicios gestionados en 2025

-

NoticiasHace 7 días

NoticiasHace 7 díasAMD despedirá al 4% de su plantilla mientras se centra en IA y centros de datos

-

NoticiasHace 3 días

NoticiasHace 3 díasEl Capitan es el nuevo superordenador más potente y rápido del mundo

-

NoticiasHace 7 días

NoticiasHace 7 díasLa Comisión Europea multa a Meta con 798 millones por perjudicar a la competencia de Marketplace