Noticias

Tesla D1, un nuevo chip para IA con una potencia de 362 TFLOPs en BF16/CFP8

La compañía que dirige Elon Musk ha presentado el Tesla D1, un nuevo chip diseñado específicamente para inteligencia artificial que es capaz de ofrecer una potencia de 362 TFLOPs en BF16/CFP8. Si miramos la potencia que alcanza en FP32 nos damos cuenta de que la cosa es bastante seria, ya que este chip es capaz de llegar a los 22,6 TFLOPs. Trabajando con matrices

No se trata de un chip modesto, ni de una solución que se amedrente frente a los que podríamos considerar como sus rivales más cercanos, pero es cierto que hacer una comparativa directa con las aceleradoras gráficas de NVIDIA y de AMD no sería del todo justa, ya que aquellas tienen un menor grado de especialización que el chip Tesla D1.

Seguimos repasando sus especificaciones, y vemos que este nuevo silicio de Tesla está fabricado en proceso de 7 nm, tiene un total de 50.000 millones de transistores, ocupa una superficie de 645 mm cuadrados, lo que significa que es más pequeño que la GPU GA100, utilizada en la aceleradora NVIDIA A100, que tiene un tamaño de 826 mm cuadrados.

El Tesla D1 suma un total de 354 nodos de entrenamiento que dan forma a una red de unidades funcionales, las cuales están interconectadas para crear un chip masivo. Cada unidad funcional viene con una CPU ISA de 64 bits y cuatro núcleos que utiliza un diseño personalizado y especializado en transposiciones, recopilaciones, difusiones y recorridos de enlaces. Esta CPU adopta una implementación superescalar (4-wide scalar y 2-wide vector pipelines). Cada unidad funcional tiene una SRAM de 1,25 MB y un ancho de banda de 512 GB/s en cualquier dirección de la red de unidades.

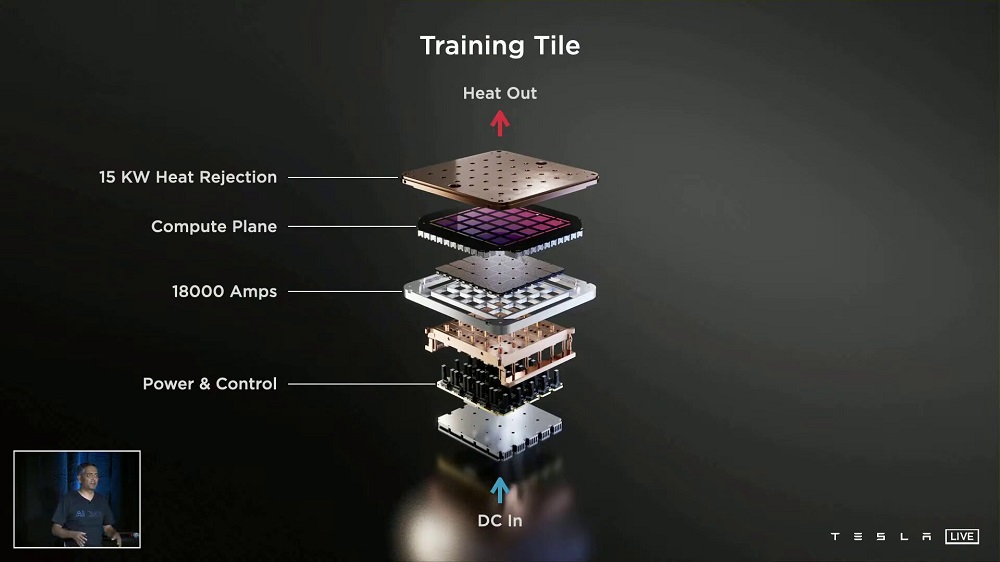

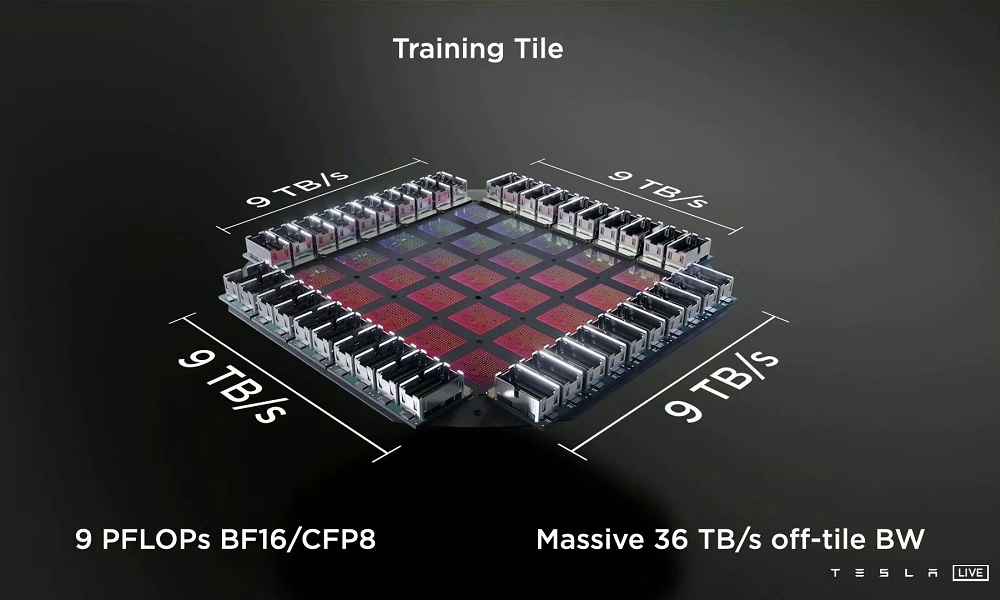

Este nuevo silicio de Tesla se puede unir en configuraciones multichip de 25 unidades Tesla D1, utilizando para ello el DIP, siglas de «Dojo Interface Processor». Su alta escalabilidad, y sus posibilidades de interconexión, permiten crear grandes redes de procesamiento de alto rendimiento. Para ilustrar esta realidad, Tesla habló del ExaPOD, una configuración con 120 «Training Tiles». Cada «Training Tile» contiene un total de 25 chips Tesla D1, lo que significa que, en total esa configuración alcanza una potencia de 1,1 ExaFLOPS en FP16/CFP8.

Una solución interesante, prometedora y altamente especializada que colocaría a Tesla, en teoría, por delante de los principales jugadores del sector, incluida NVIDIA. Habrá que ver, eso sí, el nivel de producción que alcanza y la acogida que recibe cuando esté disponible. Tesla no hablado de costes, así que esto queda como una asignatura pendiente.

-

OpiniónHace 6 días

OpiniónHace 6 días10 predicciones para los proveedores de servicios gestionados en 2025

-

NoticiasHace 2 días

NoticiasHace 2 díasEl Capitan es el nuevo superordenador más potente y rápido del mundo

-

NoticiasHace 6 días

NoticiasHace 6 díasLa Comisión Europea multa a Meta con 798 millones por perjudicar a la competencia de Marketplace

-

NoticiasHace 6 días

NoticiasHace 6 díasAMD despedirá al 4% de su plantilla mientras se centra en IA y centros de datos