A Fondo

NVIDIA GTC 2022: Hopper y Grace reafirman el liderazgo de NVIDIA

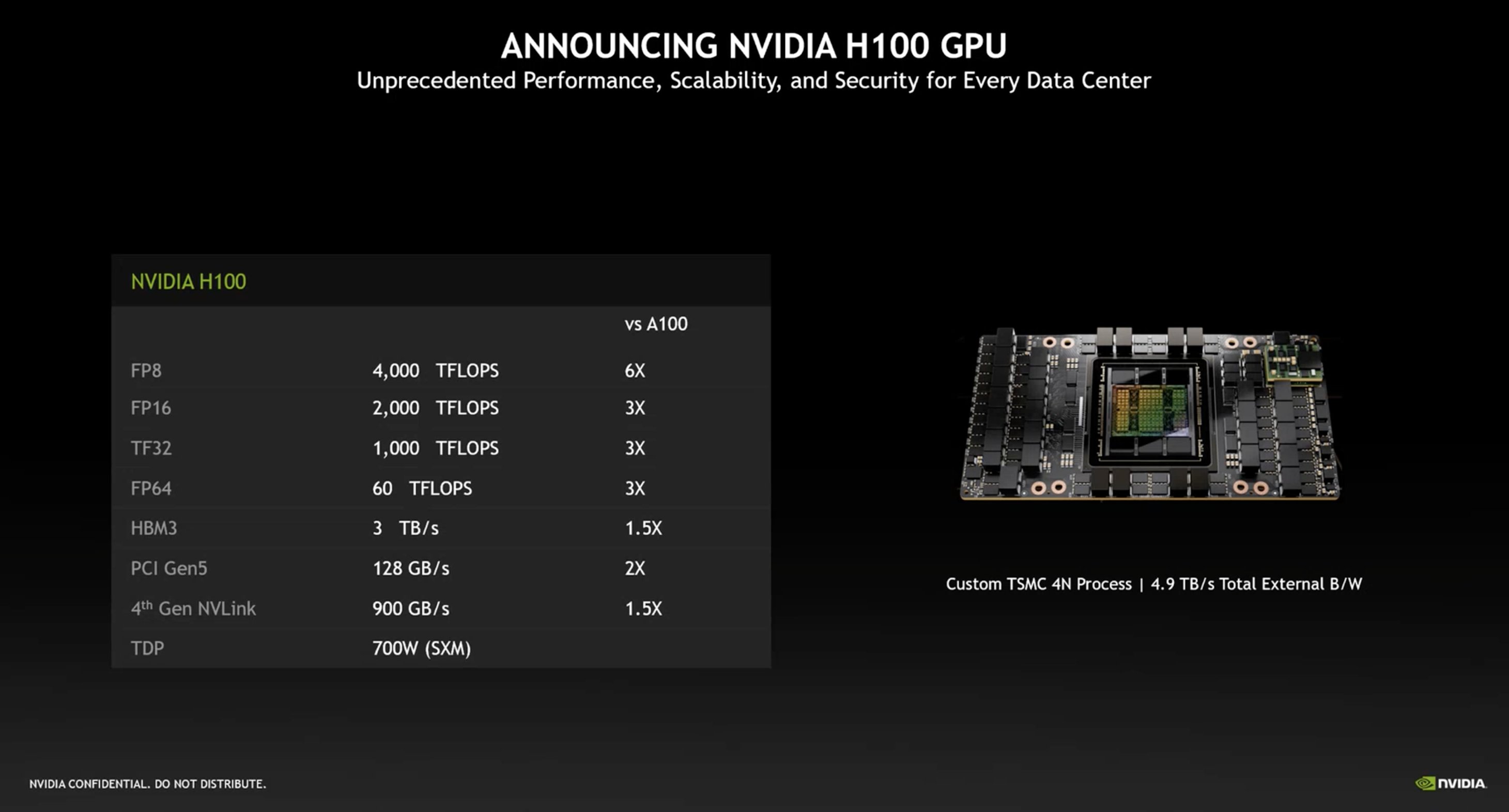

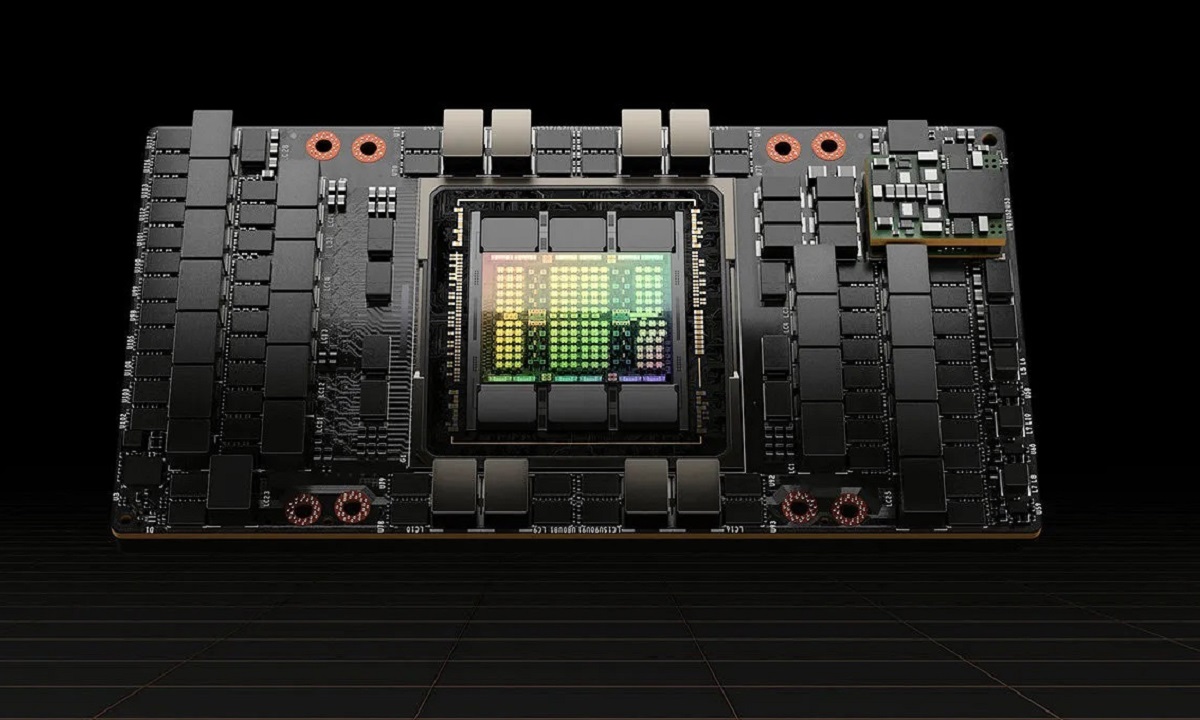

La GTC de 2022 ha empezado a lo grande. NVIDIA ha realizado anuncios muy importantes, y con ellos ha confirmado, una vez más, que se encuentra a la vanguardia del sector. En este sentido, una de las novedades más importantes ha sido Hopper, la nueva arquitectura GPU que utiliza su aceleradora NVIDIA H100, una solución extremadamente potente que suma un total de 80.000 millones de transistores, y que ofrece una potencia de hasta 1.000 TFLOPs en TF32, lo que supone un aumento del 300% frente a la NVIDIA A100.

Durante las últimas semanas habíamos visto numerosos rumores que apuntaban a que Hopper iba a ser la primera arquitectura modular de NVIDIA, pero también vimos otros que señalaban en la dirección contraria, y al final han sido estos los que se han cumplido. La NVIDIA H100 utiliza una GPU de núcleo monolítico que integra un total de 132 unidades SM en su formato SXM5, y 114 unidades SM en su versión PCIE Gen5. Esto nos deja un conteo, respectivamente, de 16.896 shaders y 14.592 shaders. Ambas versiones suman 528 y 456 núcleos tensor, especializados en inteligencia artificial, inferencia y aprendizaje profundo.

Hopper está fabricada en el nodo de 4 nm de TSMC, lo que la convierte no solo en la GPU más potente que existe hasta el momento, sino también en la más avanzada por el proceso de fabricación que utiliza.

El salto a los 4 nm de TSMC ha sido clave para que NVIDIA haya podido triplicar la potencia bruta de la NVIDIA A100, pero sin llegar ni siquiera a doblar el consumo. Y hablando de consumo, la versión PCIE Gen5 de la NVIDIA H100 tiene un TBP de 350 vatios, mientras que la versión SXM5 puede llegar a los 700 vatios.

NVIDIA H100: La GPU más potente y avanzada que existe

Al ofrecer dos formatos distintos, NVIDIA puede cubrir las necesidades de distintas empresas y llega a un número más amplio de profesionales, algo que, obviamente, es todo un acierto. El resto de las especificaciones de la NVIDIA H100 se completan con hasta 50 MB de caché L2, un bus de 5.120 bits y hasta 80 GB de memoria HBM3. En total, es capaz de alcanzar un ancho de banda de 3 TB/s, un 150% más que la NVIDIA A100, y es compatible con las últimas tecnologías y soluciones del sector.

NVIDIA también aprovechó la presentación de Hopper para hablar de los algoritmos de programación dinámica, que parten de dos grandes claves: recursión, que desmenuza un problema grande en varios problemas pequeños para facilitar su resolución, y memorización, que almacena respuestas y soluciones que pueden volver a utilizarse para resolver otros problemas.

Estos algoritmos se utilizan en numerosos sectores como el cuidado de la salud, la robótica, la computación cuántica y la investigación científica, entre otros. Según el gigante verde, la arquitectura Hopper es capaz de ofrecer una mejora de rendimiento en un factor de 40x (cuarenta veces) gracias al uso de nuevas instrucciones DPX.

Suena bien, ¿pero qué supondrá esto para los profesionales? Pues muy sencillo, las nuevas instrucciones DPX permitirán a los desarrolladores escribir código capaz de acelerar los algoritmos de programación dinámica en múltiples industrias, lo que se traducirá en un importante impulso de los flujos de trabajo en campos tan importantes como el diagnóstico de enfermedades, la simulación cuántica, el análisis de gráficos y optimizaciones a nivel de enrutamiento, algo clave en robótica.

Con NVIDIA Hopper (H100), las instrucciones DPX pueden acelerar los algoritmos de programación dinámica hasta 7 veces más que con una NVIDIA Ampere (A100). Obviamente esto escala de forma proporcional, lo que significa que con un nodo de varias aceleradoras gráficas NVIDIA H100 el salto en términos de rendimiento acaba siendo enorme. No debemos olvidarnos de que, además, Hopper utiliza los nuevos núcleos tensor de cuarta generación, especializados en IA, inferencia y aprendizaje profundo.

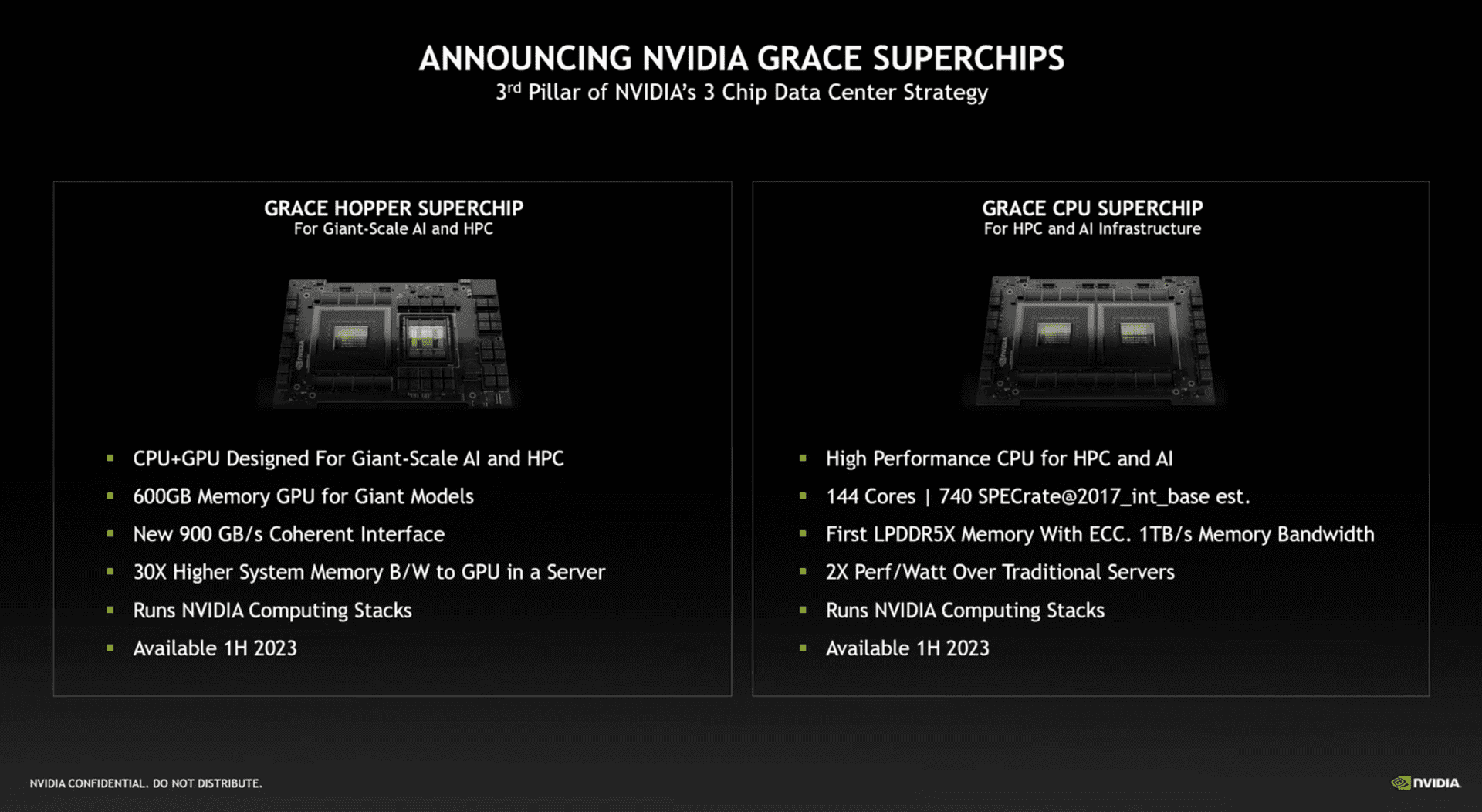

NVIDIA Grace: Una súper CPU para centros de datos

Otra de las «novedades» (entre comillas porque ya «nos conocíamos«) más importantes que ha anunciado NVIDIA en la GTC de 2022 ha sido Grace, una súper CPU orientada al sector profesional que utiliza la arquitectura ARM, y que está formada por dos procesadores unidos en un PCB e interconectados para trabajar como si fueran un único chip. Esta solución representa una de las apuestas más importantes de NVIDIA en su carrera por liderar el sector de los centros de datos, y estará disponible en dos configuraciones diferentes.

En total, NVIDIA Grace suma 144 núcleos ARM v9, una cifra espectacular que garantiza un alto rendimiento multihilo. Como cabía esperar, NVIDIA ha acompañado a Grace de memoria LPDDR5X para maximizar el rendimiento, ha confirmado un ancho de banda de 1 TB/s y la integración de tecnología ECC (corrección de errores), un detalle muy importante ya que significa que NVIDIA Grace está preparada para integrarse sin problemas en cualquier entorno de investigación científica, incluso en aquellos donde se realicen simulaciones complejas que requieran de una precisión total.

NVIDIA Grace utiliza una nueva interfaz de coherencia NVLink-C2C de cuarta generación, que alcanza los 900 GB/s, se estima que podría alcanzar una puntuación de más de 740 en SPECrate 2017_int_base, dobla el rendimiento por vatio de cualquier procesador tope de gama actual y es compatible, además, con todas las pilas y plataformas de software del gigante verde, incluyendo NVIDIA RTX, HPC, NVIDIA AI y NVIDIA Omniverse. Grace estará disponible tanto de forma independiente como en otra acompañada por Hopper, pero no llegará hasta la primera mitad de 2023.

Otras novedades importantes

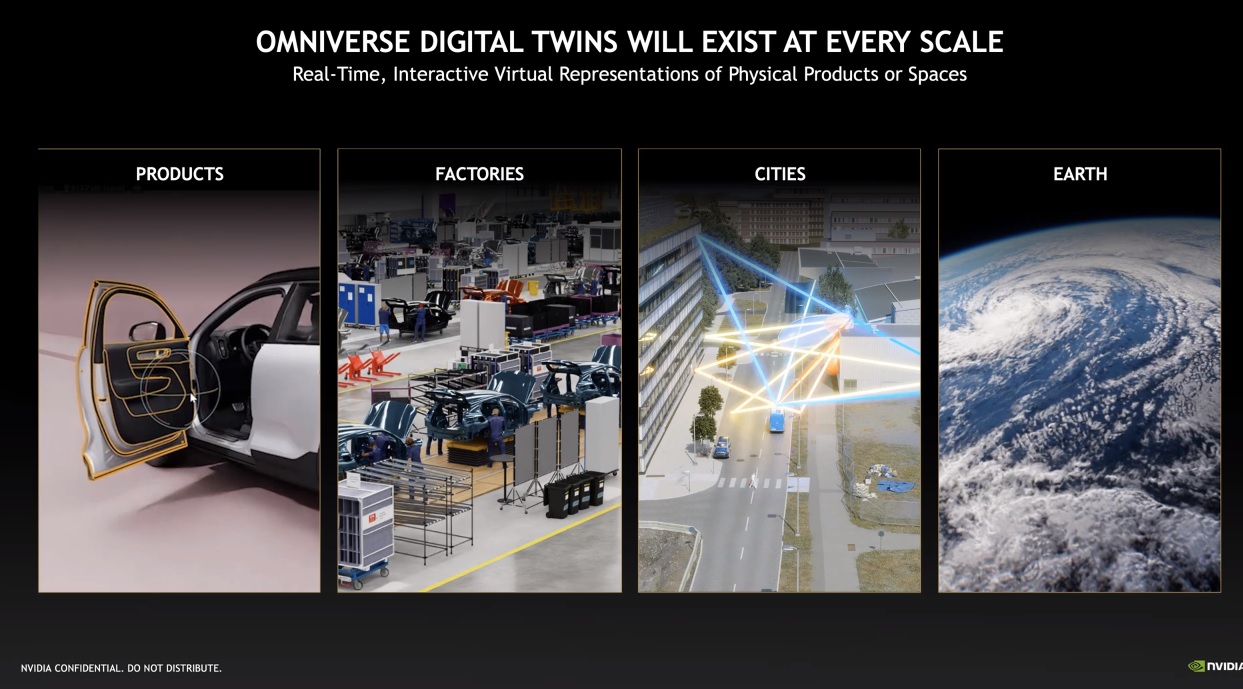

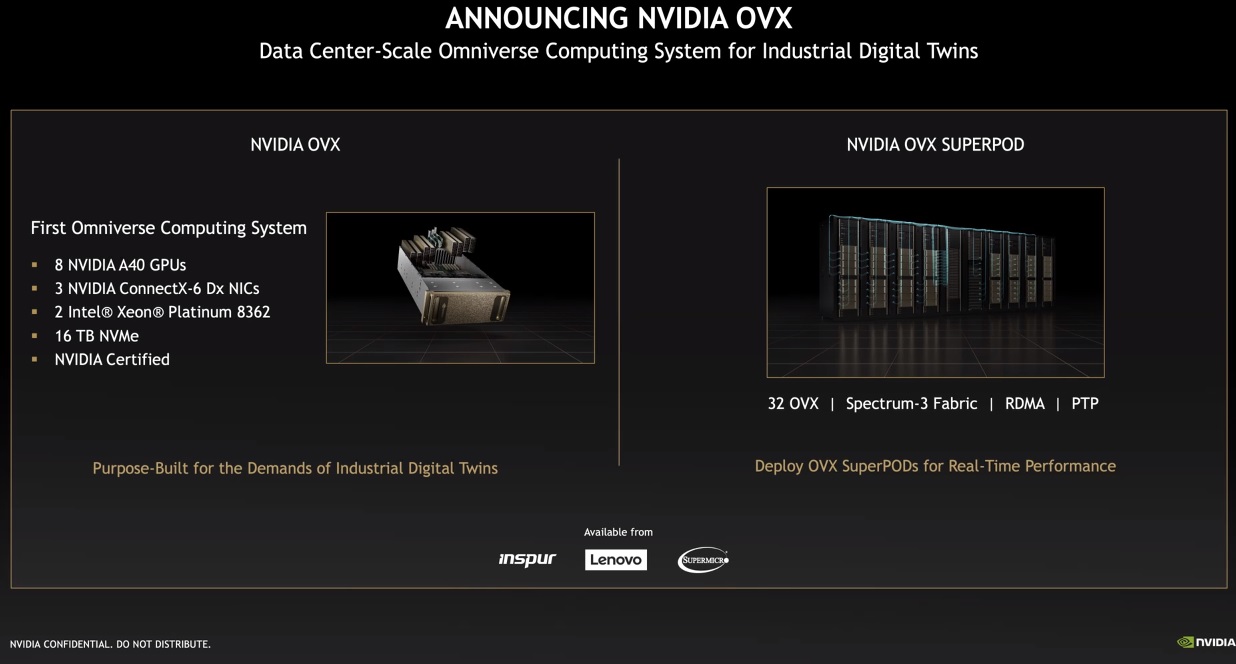

La GTC 2022 ha dado para mucho, eso es innegable. NVIDIA ha presentado una gran cantidad de novedades, entre las que podemos destacar Omniverse Cloud para desarrolladores, sobre la que ya os hemos hablado en este artículo, Omniverse Avatar, NVIDIA Spectrum-4, NVIDIA OVX y el NVIDIA OVX SuperPod.

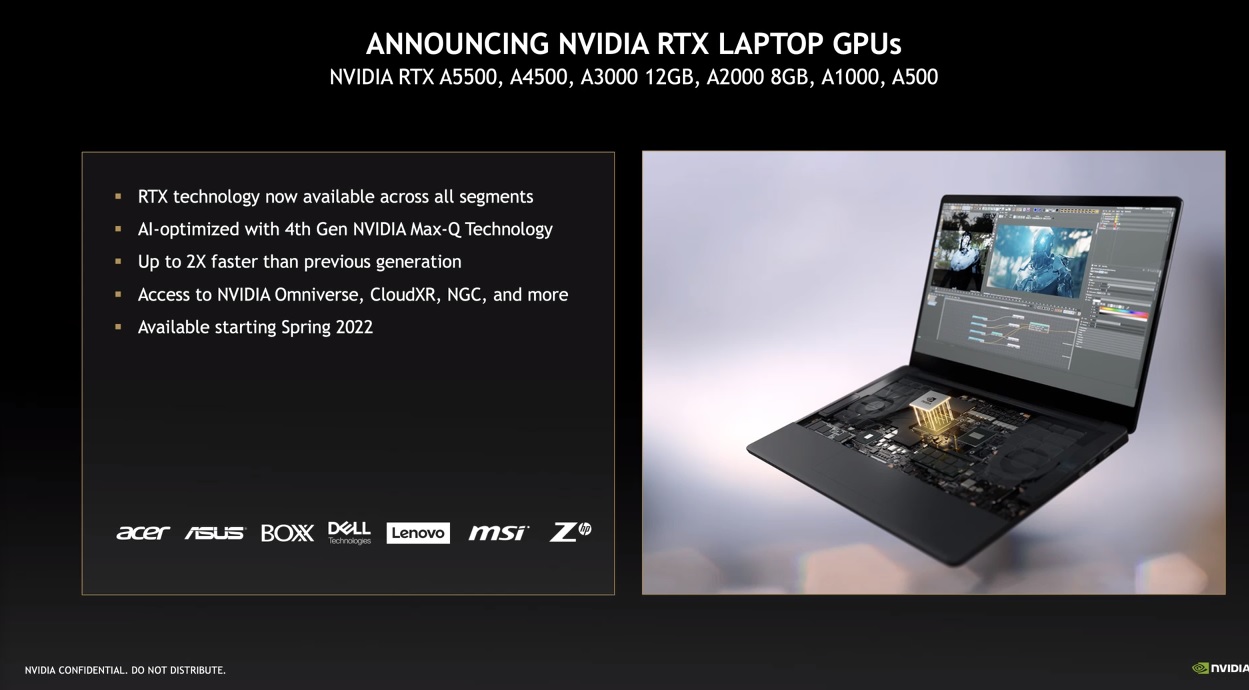

En MuyComputer también os hemos hablado de las nuevas RTX A5500 para profesionales, y de las nuevas soluciones profesionales para equipos portátiles basadas en la tecnología Max-Q de cuarta generación, que serán utilizadas por los principales jugadores del sector portátil, incluyendo a gigantes como Acer, ASUS, Dell, Lenovo, MSI y HP.

No podemos terminar sin hablar de la NVIDIA DGX Station H100, un superordenador que se perfila como la solución más rápida de su clase trabajando con IA. Está formado por 8 aceleradoras gráficas H100, alcanza un pico de rendimiento de 32 PETAFLOPs en cargas de trabajo de inteligencia artificial y suma hasta 640 GB de memoria HBM3, cuyo ancho de banda es de 24 TB/s. Esta es, además, la «unidad básica» del NVIDIA EOS, un súper ordenador que integra la friolera de 576 bloques DGX Station H100, lo que se traduce en 4.608 GPUs H100.

-

OpiniónHace 6 días

OpiniónHace 6 días10 predicciones para los proveedores de servicios gestionados en 2025

-

NoticiasHace 6 días

NoticiasHace 6 díasAMD despedirá al 4% de su plantilla mientras se centra en IA y centros de datos

-

NoticiasHace 2 días

NoticiasHace 2 díasEl Capitan es el nuevo superordenador más potente y rápido del mundo

-

NoticiasHace 6 días

NoticiasHace 6 díasLa Comisión Europea multa a Meta con 798 millones por perjudicar a la competencia de Marketplace